درخت تصمیم

درخت تصمیم یکی از قدرتمندترین و پرکاربردترین الگوریتمهای یادگیری ماشین و دادهکاوی است که در مسائل دستهبندی و پیشبینی مورد استفاده قرار میگیرد. این الگوریتم به صورت یک ساختار درختی تصمیمی توصیف میشود که به سادگی قابل تفسیر برای انسانها است و میتواند الگوها و قوانین مختلف را در دادهها شناسایی کند.

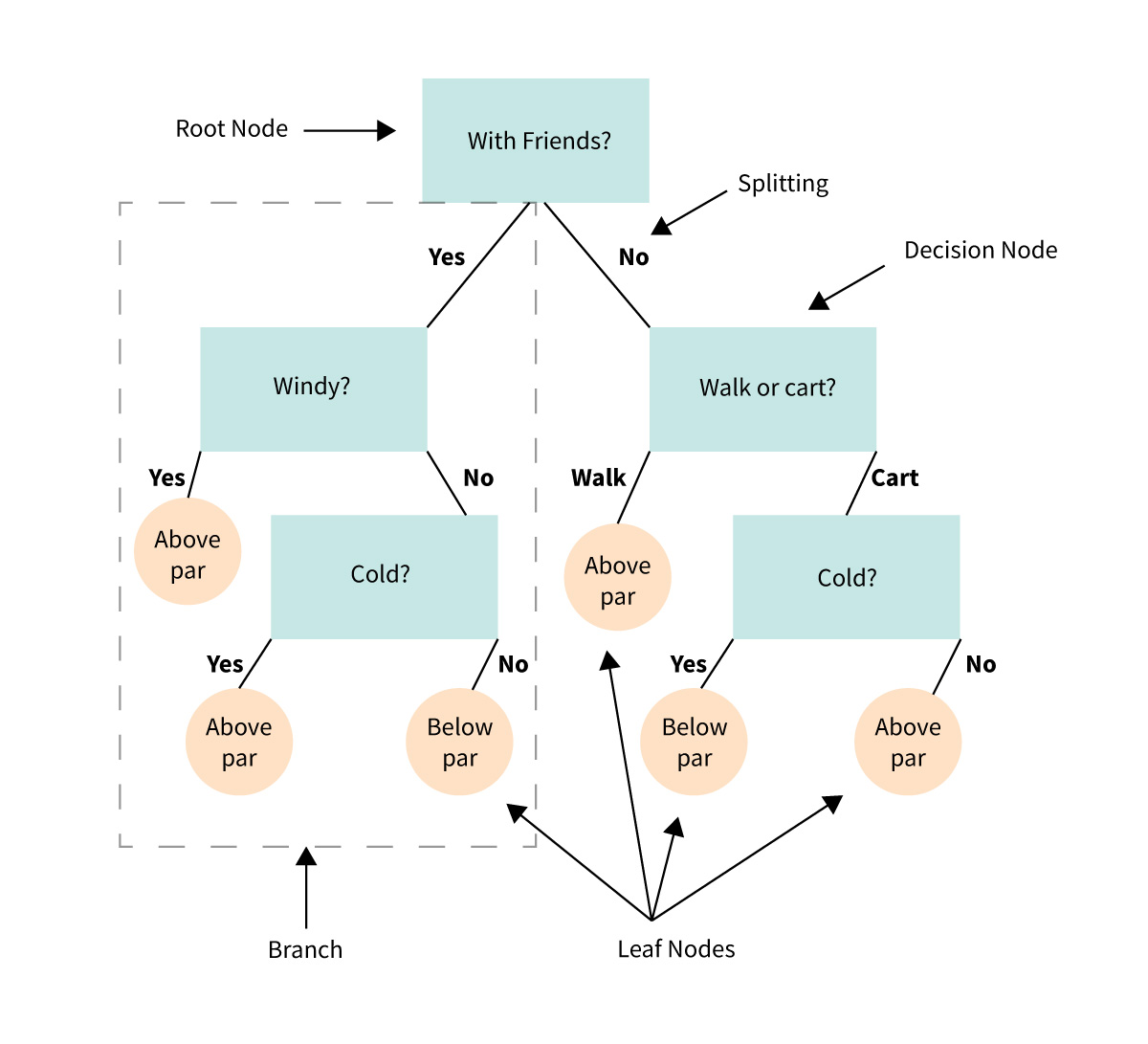

درخت تصمیم از گرهها و شاخهها تشکیل شده است. درخت با یک گره اصلی شروع میشود که به عنوان “گره ریشه” شناخته میشود. از این گره ریشه، درخت به شکل شاخهها به سمت پایین گسترش مییابد. هر گره داخلی از یک ویژگی خاص انتخاب شده برای تقسیم دادهها به دو یا چند شاخه نمایانگر ویژگیها شکل میگیرد. سپس هر شاخه به یک گره داخلی دیگر یا به یک “سربرگ” (Leaf Node) منتهی میشود.

در سربرگها تصمیم نهایی برای دادهها گرفته میشود. آنها به یک دسته خاص تعلق میگیرند. این دستهها میتوانند دستههای مختلف برای مسئله دستهبندی یا مقادیر پیشبینی شده برای مسئله رگرسیون باشند. رگرسیون خطی در یادگیری ماشین و رگرسیون لجستیک در یادگیری ماشین کاربردهای بسیاری دارند.

در ادامه درباره ساختار درخت تصمیم و کاربردهای آن صحبت میکنیم. با ورود به آکادمی تخصصی هوش مصنوعی مهسا، شما میتوانید بخشی از این رویای پیشرفت تکنولوژیک شوید و مهارتهایی که برای ساخت این آینده لازم است را یاد بگیرید.

تعریف درخت تصمیم و کاربردهای آن

درخت تصمیم یک مدل مفهومی است که در علوم کامپیوتر و هوش مصنوعی مورد استفاده قرار میگیرد. این مدل به شکل یک ساختار درختی اطلاعات را نمایش میدهد تا برای حل مسائل و تصمیمگیریهای پیچیده مفید باشد. از جمله کاربردهای درخت تصمیم عبارتند از:

- کلاسبندی: در مسائل کلاسبندی مانند تشخیص اشیاء، تصمیمگیری در مورد تقسیم دادهها به دستههای مختلف با استفاده از درخت تصمیم میتواند مفید باشد.

- پیشبینی: در مسائل پیشبینی مثل پیشبینی قیمتها یا ترافیک، درخت تصمیم به کمک میآید تا مدلی برای پیشبینی نتایج بسازیم.

- تصمیمگیری: در مسائل تصمیمگیری چون بهینهسازی مسائل تولید، مدیریت منابع، و مسائل مشابه، درخت تصمیم به تصمیمگیران کمک میکند تا مسیر بهینه را انتخاب کنند.

- یادگیری ماشین: درخت تصمیم یکی از الگوریتمهای یادگیری ماشینی است که برای ساخت مدلهای پیشبینی و کلاسبندی مورد استفاده قرار میگیرد.

- فیلتر کردن اطلاعات: میتوان از درخت تصمیم برای فیلتر کردن دادهها و حذف اطلاعات غیرمهم استفاده کرد.

در کل، درخت تصمیم یک ابزار قدرتمند برای تصمیمگیری و حل مسائل با ویژگیها و کاربردهای متعدد در علوم کامپیوتر و مهندسی است.

تعریف داده کاوی

دادهکاوی یک فرآیند تحلیلی است که در آن اطلاعات موجود در مجموعههای داده بزرگ، به دنبال الگوها، روابط و اطلاعات مفهومی مخفی در دادهها میگردد. این فرآیند به منظور استخراج دانش و اطلاعات مفهومی از دادهها برای اهداف مختلفی مانند پیشبینی، تصمیمگیری و بهبود عملکرد استفاده میشود. ویژگیهای اصلی دادهکاوی عبارتند از:

- استخراج الگوها: دادهکاوی به دنبال الگوها و ساختارهای مخفی در دادهها میگردد تا اطلاعات مفهومی به دست آید.

- پیشبینی: با تحلیل دادهها، میتوان الگوها و روابطی را شناسایی کرد که به پیشبینی نتایج آینده کمک میکنند. مثلاً در پیشبینی تغییرات قیمتها یا عملکرد بازار.

- تصمیمگیری: دادهکاوی میتواند به تصمیمگیریهای بهتر در مسائل مانند بهینهسازی منابع، توصیهها به مشتریان و مدیریت ریسک کمک کند.

- اکتشاف دانش: با تحلیل دادهها، میتوان دانش جدید و مفهومی در زمینههای مختلف را کشف کرد.

دادهکاوی از ابزارها و تکنیکهای متعددی مانند الگوریتمهای یادگیری ماشینی، تجزیه و تحلیل آماری، و تکنیکهای مختلفی برای پردازش دادهها بهره میبرد. این فرآیند در صنایع مختلف از جمله تجارت، پزشکی، مالی، و علوم اجتماعی به کار میرود تا اطلاعات مهم و ارزشمندی از دادههای بزرگ استخراج شود.

کاربرد درخت تصمیم در داده کاوی

درخت تصمیم یکی از الگوریتمهای مهم در دادهکاوی و یادگیری ماشین است و در متناسب با کاربردهای مختلف دادهکاوی میتواند به شکلهای متنوعی مورد استفاده قرار گیرد. این الگوریتم دارای کاربردهای متعددی در دادهکاوی است که به شرح زیر میباشد:

- کلاسبندی (Classification): یکی از کاربردهای اصلی درخت تصمیم در دادهکاوی، کلاسبندی دادهها است. مثلاً در مسائل تشخیص اسپم ایمیل، بر اساس ویژگیهای مختلف ایمیلها را به دو دسته “اسپم” و “غیر اسپم” تقسیم میکند.

- پیشبینی (Prediction): درخت تصمیم به عنوان یک مدل پیشبینی مورد استفاده قرار میگیرد. مثلاً میتوان از آن برای پیشبینی قیمتهای مسکن بر اساس ویژگیهای مختلف استفاده کرد.

- تصمیمگیری (Decision Making): در مسائل تصمیمگیری مانند بهینهسازی منابع، درخت تصمیم به تصمیمگیران کمک میکند تا مسیر بهینه را انتخاب کنند. مثلاً در تخصیص منابع برای پروژهها.

- گروهبندی (Clustering): اگرچه درخت تصمیم به طور اصلی برای کلاسبندی استفاده میشود، اما میتواند در برخی موارد برای گروهبندی دادهها به شکل دستههای مشابه استفاده شود.

- کشف الگوها (Pattern Discovery): درخت تصمیم میتواند الگوها و ساختارهای مخفی در دادهها را کشف کند. این کشف الگوها میتواند اطلاعات مهمی را ارائه دهد.

- مدیریت دانش (Knowledge Management): درخت تصمیم به عنوان یک وسیله برای مدیریت دانش و توصیف الگوها و روابط در دادهها مورد استفاده قرار میگیرد.

با توجه به این کاربردها، درخت تصمیم یکی از ابزارهای قدرتمند در دادهکاوی است که به تصمیمگیری و استخراج دانش از دادهها کمک میکند.

اجزای درخت تصمیم

درخت تصمیم از اجزای اصلی زیر تشکیل شده است:

- گرهها (Nodes): در درخت تصمیم، گرهها نقاطی هستند که دادهها در آنها تقسیم میشوند یا تصمیمها در آنها گرفته میشود. دو نوع گره اصلی وجود دارد که شامل گره ریشه و گرههای داخلی است.

- یالها (Edges): یالها ارتباطات بین گرهها را نشان میدهند. آنها نشاندهنده جریان تصمیمات از یک گره به گره دیگر و از ریشه به سربرگها هستند.

- سربرگها (Leaf Nodes): گرههای پایانی درخت به عنوان سربرگها شناخته میشوند. در این گرهها تصمیم نهایی گرفته میشود و داده به یک دسته خاص تعلق میگیرد یا مقداری پیشبینی میشود.

- ویژگیها (Features): ویژگیها متغیرهایی هستند که برای تقسیم دادهها در گرههای داخلی استفاده میشوند. در هر گره داخلی، یک ویژگی انتخاب میشود تا دادهها بر اساس آن تقسیم شوند.

- کرانهای تصمیم (Decision Criteria): در هر گره داخلی، یک کران تصمیم مشخص میشود که بر اساس آن دادهها به شاخههای مختلف تقسیم میشوند. مثلاً در یک گره داخلی میتواند کران تصمیمی بر اساس مقدار عددی یک ویژگی باشد.

- شاخهها (Branches): شاخهها نشاندهنده تقسیم دادهها در هر گره داخلی بر اساس کران تصمیمی هستند. این شاخهها به گرههای داخلی یا سربرگها اتصال دارند.

- خط تصمیم (Decision Path): خط تصمیم یک مسیر از گره ریشه به یک سربرگ خاص در درخت تصمیم را نشان میدهد و نشاندهنده تصمیمهایی است که برای دستهبندی یک نمونه داده از ریشه به سربرگ طی میشود.

این اجزای اصلی درخت تصمیم به عنوان ابزار اساسی در دادهکاوی و یادگیری ماشین مورد استفاده قرار میگیرند تا مدلهای تصمیمگیری برای تجزیه و تحلیل دادهها و پیشبینی نتایج ایجاد شود.

معیار مناسب برای انتخاب انشعاب

انتخاب معیارهای مناسب برای انشعاب درخت تصمیم یکی از مراحل مهم در طراحی این درختها است. معیارهای انتخاب ویژگی یا مشخصه به کمک الگوریتمهای درخت تصمیم، میزان اهمیت ویژگیها را برای تصمیمگیری در هر گره داخلی تعیین میکنند. در ادامه، برخی از معیارهای معروف برای انتخاب ویژگیها در درخت تصمیم آورده شده است:

- Entropy (آنتروپی): این معیار بر اساس مفهوم اطلاعاتی و تفاوت بین دستههای مختلف دادهها اندازهگیری میشود. هدف این معیار کمینه کردن آنتروپی (ناخالصی) در هر گره داخلی است، که به انتخاب بهترین ویژگی برای تقسیم دادهها منجر میشود.

- Gini Impurity (تلخی ژینی): این معیار میزان تلخی (یا ناخالصی) دادهها در هر گره داخلی را اندازهگیری میکند. هدف این معیار کمینه کردن تلخی ژینی در گرههای داخلی و انتخاب بهترین ویژگی برای تقسیم دادههاست.

- Information Gain (بهبود اطلاعات): این معیار تفاوت بین اطلاعات قبل و بعد از تقسیم دادهها بر اساس ویژگی مورد نظر را اندازهگیری میکند. هدف این معیار انتخاب ویژگی با بیشترین بهبود اطلاعات (بزرگترین Information Gain) است.

- Gain Ratio (نسبت بهبود): این معیار Information Gain را با توجه به تعداد شاخههایی که ویژگی مورد نظر دارد تنظیم میکند. این معیار به عنوان یک بهبود برای Information Gain بهره میبرد تا بهترین ویژگی انتخاب شود.

- Chi-Square (کای-مربع): این معیار میزان تفاوت میان فراوانی مشاهدهشده و فراوانی مورد انتظار برای دادهها در هر گره را محاسبه میکند. این معیار برای تشخیص تأثیر ویژگی بر دستهبندی دادهها استفاده میشود.

- CART (Classification and Regression Trees): در روش CART، از معیار Gini Impurity برای کلاسبندی و تلخی ژینی برای پیشبینی عددی (رگرسیون) استفاده میشود. این الگوریتم درخت تصمیم را برای هر نوع مسئله (دستهبندی و رگرسیون) قابل استفاده میکند.

انتخاب معیار مناسب برای مسئله خاص شما و ویژگیهای دادههایتان بستگی به ماهیت مسئله و هدف تصمیمگیری دارد.

هرس کردن درخت تصمیم

هرس کردن این الگوریتم یک مرحله مهم در فرآیند ساخت و بهینهسازی این درختها در دادهکاوی و یادگیری ماشینی است. این امر به معنی حذف بعضی از شاخهها یا گرههای درخت تصمیم است تا درخت سادهتر و با پیچیدگی کم شود و از بیشبرازش (Overfitting) جلوگیری کند. هدف از این کار درخت تصمیم، سادهتر کردن مدل به گونهای که به مسائل جدید تعمیمپذیر باشد و از بیشبرازش درخت به دادههای آموزشی جلوگیری کند. همچنین، این کار میتواند مدل را قابل فهمتر کند و راهنمایی برای تصمیمگیریهای بهتر ارائه دهد. در ادامه روش هایی برای هرس این الگوریتم بیان می شود

پایان دهنده زودرس (Early Stopping)

یکی از روشهای اصلی برای هرس درخت تصمیم، استفاده از پایان دهنده زودرس (Early Stopping) است. این روش به این معناست که ساختار درخت را به مرحلهای معین یا با توجه به یک شرط معین قطع میکنیم. این مرحله ممکن است بر اساس تعداد گرهها، عمق درخت، یا تعداد نمونهها در هر گره مشخص شود.

حذف شاخهها (Pruning)

حذف بعضی از شاخهها و گرهها از درخت تصمیم به عنوان یک روش هرس معمولی به کار میرود. این الگوریتم در حالت ابتدایی ممکن است بسیار پیچیده باشد و شامل شاخههایی با اطلاعات نامفهومی باشد که با حذف آن ها از درخت، سادهتر و قابل فهمتر میشود.

استفاده از الگوریتمهای مناسب

الگوریتمهای مناسب عبارتند از:

- Random Forest: از آنجا که Random Forest مجموعهای از درختهای تصمیم است، امکان هرس هر درخت جزئی از این مجموعه و ترکیب درختهای هرسشده وجود دارد.

- Gradient Boosting: الگوریتمهای یادگیری چند درختی مانند XGBoost و LightGBM به صورت تدریجی درختهای ضعیف تولید کرده و با هرس درختها در مراحل مختلف، بهبود عملکرد حاصل میکنند.

الگوریتم های درخت تصمیم

برای ساخت درخت تصمیم در مسائل ماشین لرنینگ و دادهکاوی، از الگوریتمهای مختلفی استفاده میشود. الگوریتمهای شایع برای ساخت درخت تصمیم عبارتند از:

- CART (Classification and Regression Trees): این الگوریتم به عنوان یکی از معروفترین و محبوبترین الگوریتمهای درخت تصمیم برای مسائل دستهبندی و رگرسیون استفاده میشود. CART از معیار Gini Impurity برای دستهبندی و تلخی ژینی برای پیشبینی عددی (رگرسیون) استفاده میکند.

- ID3 (Iterative Dichotomiser 3): این الگوریتم از معیار Entropy برای انتخاب ویژگیها برای دستهبندی استفاده میکند. از آنجا که از Entropy استفاده میکند، معمولاً برای مسائل دستهبندی استفاده میشود.

- C4.5: این یک ارتقای به ID3 است و از معیارهای Entropy و Gain Ratio برای انتخاب ویژگیها استفاده میکند. C4.5 به صورت پویا و با توجه به تغییرات درخت تصمیم ساخته میشود.

- Random Forest: این الگوریتم، یک مجموعه از درختهای تصمیم است که به صورت تصادفی ساخته میشوند و در نهایت نتایج آنها ترکیب میشود. این الگوریتم به خوبی از بیشبرازش جلوگیری میکند و به دقت و قوت مدل کمک میکند.

- Gradient Boosting Trees (مانند XGBoost و LightGBM): این الگوریتمها از چند درخت تصمیمی ضعیف برای ساخت یک مدل قوی استفاده میکنند. هر درخت به تدریج ساخته میشود و با توجه به خطاهای مدل قبلیاش، درختهای جدید تولید میکنند.

- CHAID (Chi-Squared Automatic Interaction Detection): این الگوریتم از معیارهای کای-مربع برای ساخت درخت تصمیم استفاده میکند. این الگوریتم به صورت خاص برای مسائل دستهبندی و ایجاد درختهای تصمیمی با توجه به تفاوتهای آماری بین متغیرها استفاده میشود.

هر کدام از این الگوریتمها و سایر الگوریتمهای موجود دارای ویژگیها و مزایا و معایب خاصی هستند. انتخاب الگوریتم مناسب برای مسئله خاصی بستگی به ماهیت دادهها و هدف تصمیمگیری دارد. همچنین، هرگز فراموش نکنید که در هرس و بهینهسازی درختها نقش مهمی دارد تا مدل بهتر و پیچیدگی کم ایجاد شود.

مزایای درخت تصمیم

درخت تصمیم یکی از الگوریتمهای مهم و محبوب در زمینههای دادهکاوی و یادگیری ماشینی است. این الگوریتم دارای مزایای متعددی است که آن را جذاب و مورد استفاده در مسائل مختلف میکنند. مزایای این الگوریتم عبارتند از:

- سادگی و قابل فهم: این الگوریتم به علت ساختار شبه-بنیادین و درختی که از گرهها و شاخهها تشکیل شده است، بسیار قابل فهم برای انسانها است.

- انعطافپذیری: درخت تصمیم میتواند برای مسائل دستهبندی و پیشبینی در مختلف حوزهها و با تعداد متغیرهای مختلف استفاده شود. این انعطافپذیری، آن را به یک ابزار کارآمد در مسائل متنوع میکند.

- قابلیت کار با دادههای عددی و دستهای: این الگوریتم به راحتی میتواند با دادههای عددی و دستهای کار کند. این الگوریتم میتواند به عنوان یک مدل دستهبندی و رگرسیون عمل کند.

- قابلیت مدیریت مفهوم توصیفی: این الگوریتم به صورت طبیعی مفهومها و الگوهای توصیفی در دادهها را مدیریت میکند.

- مقاومت در برابر دادههای نامرتبط و مفقودی: این الگوریتم معمولا مقاوم به مقدارهای مفقود (missing values) و دادههای نامرتبط (irrelevant features) است.

- تفسیرپذیری: این الگوریتم امکان تفسیر نتایج و توجیه تصمیمگیریها را فراهم میکند. به راحتی میتوان مسیر تصمیمگیری در درخت را تبیین کرد و عوامل موثر در تصمیمگیری را شناسایی کرد.

امروزه، با گستردگی هوش مصنوعی، کاربرد هوش مصنوعی و کاربرد ماشین لرنینگ بسیار فراوان است. آکادمی تخصصی هوش مصنوعی مهسا یک فرصت استثنایی برای یادگیری فراهم میکند. همین امروز به ما بپیوندید تا با هوش مصنوعی در روانشناسی و خطرات هوش مصنوعی آشنا شوید.

دیدگاهتان را بنویسید